-

[ADsP]_1빅데이터 분석/Study 2023. 5. 1. 18:00

다차원척도법(MDS)

> 객체간 근접성을 시각화하는 통계기법

> 계랑적 MDS 비율척도, 구간척도 데이터 활용

> 비계량적 MDS 순서척도 데이터 활용

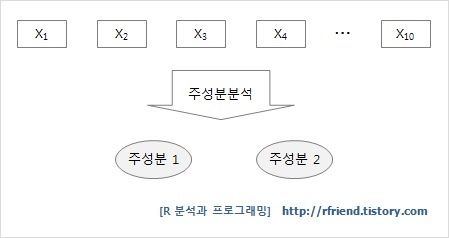

주성분분석(Principal Component Analysis)

> 여러 변수들의 상관관계, 연관성을 이용해 소수의 주성분 또는 요인으로 차원을 축소하는 것

> 데이터를 이해하기 쉽고 관리하기 쉽게 해줌

> 회귀분석이나 의사결정나무 등의 모형 개발 시 입력변수들 간의 상관관계가 높은 다중공산성이 존재할 경우 모형이

잘못만들어지고 해석에도 문제가 생김

> 다중공선성이 존재할 경우 해결 방법 중 하나가 바로 상관도 높은 변수들을 하나의 주성분 혹은 축소하여 모형 개발에 활용하는 것

> 가장 폭 넓다는 것을 통계량으로 표현하자면 분산이 가장 크게 되는 축 (분산 = 넓게 퍼진 정도)

> 데이터를 가장 넓게 설명할 수 있는 축을 PC1, 제 1 주성분

> 제 1 주성분의 영향을 뺀 후, 다음으로 가장 분산이 큰 축, 제 1 주성분과 직교하는 선

> (3) 몇 번째 주성부까지 필요할까? Scree Plot 으로 꺽임 그래프를 통해 선별함

앙상블 분석

: 여러개의 예측모형들을 만든 후 조합

> 배깅 : 여러개의 부스트랩 자료를 생성한 후 각 자료에 예측모형을 만든 후 결합

> 부스팅 : 배깅과 다른 점은 각 자료에 동일한 가중치를 주는 것이 아닌 분류가 잘못된 데이터에 더 큰 가중을 준다

> 랜덤포레스트 : 배깅에 랜덤과정을 추가한 방법

장점: 1) 과적합을 방지해 성능을 높여준다

2) 성능이 낮은 모델의 경우 앙상블로 성능을 향상시킬 수 있다3) 이상 값에 대한 대응력이 높다

단점: 모델 결과 해석이 어렵고, 소요 시간이 오래 걸린다.표본 추출 방법

> 단순랜덤 추출법 : 말 그대로 랜덤하게 표본을 뽑음

> 계통추출법: 번호를 랜덤하게 부여한 후 특정한 간격별로

> 집락추출법(군집추출) : 군집을 나눈 후 (군집 1, 군집 2, 군집 3) 군집별로 단순랜덤 추출

> 층화추출법 : 계층을 고루 대표할 수 있도록 표본추출 - 20대 남자 중 몇 명, 20대 여자 중 몇 명

가설검정

> 귀무가설 : 비교하는 값과 차이가 없다를 기본개념으로 하는 가설

ex) 우리 반 평균키는 대한민국 남성 평균키보다 크다 라는 주장에 가설검정을 한다면 귀무가설은 우리반

평균키는 대한민국 남성 평균키와 차이가 없다 를 가설로 두는 것

> p 값 : 귀무가설이 사실일 때( 차이가 없다는 것이 사실일 때), 관측된 검정통계량(관찰된 표본으로부터 구한 통계량)이 대립가설을 지지하는 방향으로 나올 확률 -> 기존 가설과 차이가 발생 학 활률

> p-value : 귀무가설이 사실인데도 불구하고 사실이 아니라고 판정할 때 실제 확률

> 유의수준 : 귀무가설이 옳은데도 이를 기각하는 확률의 크기

*제시 된 가설에 대한 해석을 할 수 있어야 함 ( ex 귀무가설이 체택될 때 가정은 평균 임금 100달러이다 등)

*p-value 값이 0.05 일 때 ~~한 경우 귀무가설을 지지하는 것이다

* 다른 조건이 모두 동일할 때 제 1종 오류의 확률이 줄어들면 제 2종 오류의 확률이 늘어나는지 등

시계열자료: 시간의 흐름에 따라 관찰된 값

정상 시계열

> 모든 시점에 대해 일정한 평균과 분산을 가진다

> 특정한 시차의 길이를 갖는 자기공분산을 측정하더라도 동일한 값을 갖는다

비정상시계열을 정상시계열로 전환하는 방법

> 평균이 일정하지 않은 경우: 원시계열에 차분 (현 시점에서 전 시점 자료값 뺌)

> 계절성을 갖는 경우 : 계절차분 사용

> 분산이 일정하지 않은 경우 : 자연로그 취함 ('변환')

> 시계열에 영향을 주는 일반적인 요인을 시계열에서 분리해 분석하는 방법을 분해시계열이라 한다

> 전체 시계열 자료를 이용하여 평균을 구하고, 최근 시계열에 더 큰 가중치를 적용하는 방법을 지수평활법이라 한다.

> 분산은 시점에 의존하지 않는다

> 공분산은 단지 시차에만 의존하고 실제 어느 시점에는 의존하지 않는다

과거 관찰값을 바탕으로 미래를 예측하기 위해서는 수집된 관측값이 안정적으로 유지되고 있는 상태인지, 또는 계속해서 변동하는 상태인지 확인해야 함. 시계열의 안정적 수준이 바로 "정상성" 이며, 정상성이란 변하지 않고 일정한 상태를 의미함. 즉, 시계열 관측값이 안정적인 상태일 때 가지는 평균과 분산을 파악하고, 여기에 추세와 계절성 등의 성분을 한 층씩 더해 예측 값을 만들어 내는 것.

데이터 정규성 확인법

> Q-Q Plot , Shaprio-Wilks test , 히스토그램

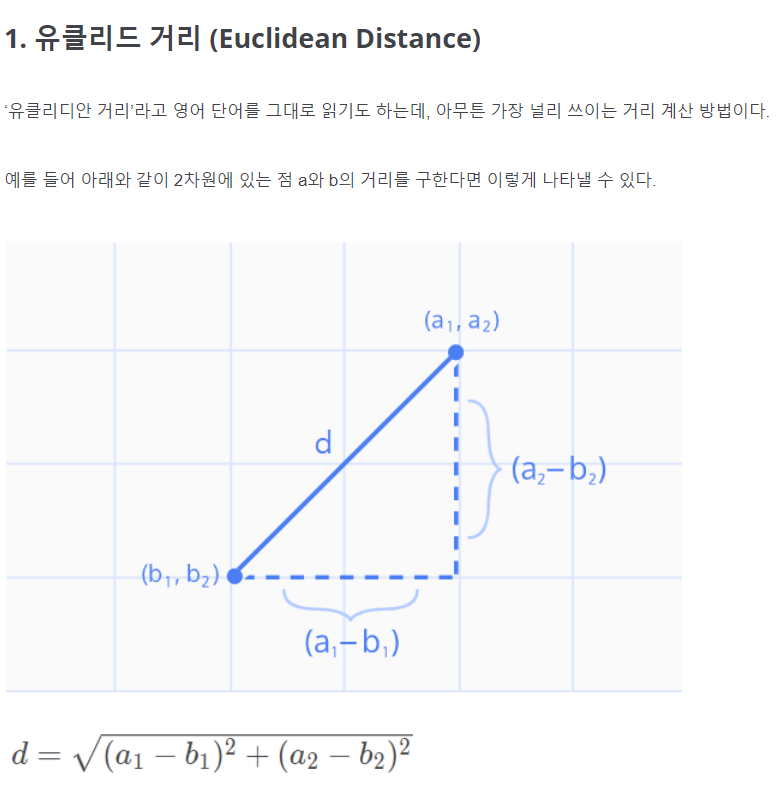

연속형 변수 거리

> 유클리디안 거리 : 우리가 흔히 아는 좌표계에서의 거리

> 표준화 거리: 표준화하게 되면 척도, 분산의 차이로 인한 왜곡을 피할 수 있다

> 마할라노비스 거리 : 통계적 개념 포함, 변수의 표준화와 상관성을 동시에 고려

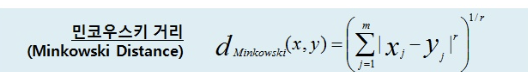

> 맨하탄 거리, 민코우스키 거리 : 책의 식 확인

유클리드 거리와 맨하탄 거리를 일반화한 거리로 나타낸 것 데이터 거버넌스

: 모든 데이터에 대하여 표준화된 관리쳬계를 수립하고 운영을 위한 프레임 워크 및 저장소 구축하는 것

> 구성 요소 : 조직 원칙 프로세스> 관리 대상 : 마스터 데이터, 메타 데이터, 데이터 사전

> 뭔가를 구축한다는 내용이 있으면 데이터 표준화

> 관리한다는 내용이 있으면 데이터 관리 체계

> 저장소 내용이 있으면 데이터 저장소 관리*마스터데이터 : 자주 변하지 않고 자료처리 운영에 기본자료로 제공되는 자료의 집합

-> 마스터 데이터는 기준 정보를 의미함. sk 하이닉스 같은 경우 제품코드, 자재코드 등이 여기에 해당

*메타데이터: 데이터에 관한 구조화된 데이터로 다른 데이터를 설명해주는 데이터

ex) HTML 태그

HTML 태그 안에 head나 body가 있으며, body안에는 table이 올 수 있고, table 안에는 tr이, tr안에는 td가 올 수 있는 것 처럼 데이터가 상위에서 하위로 나무 형태의 구조를 이루고 있다는 의미

-> 데이터를 빨리 찾기 위해서 , 데이터를 위한 데이터 / 메타 데이터를 이용해서 특정 정보 빠르게 찾을 수 있음

*데이터사전: 자료에 관한 정보를 모아두는 저장소 , 자료의 이름, 표현방식, 자료의 의미와 사용방식, 다른 자료와의 관계를 저장

ex) 사용자 정보 (아이디, 패스워드, 권한 등)

ex) 데이터 베이스 객체 정보 (테이블, 뷰, 인덱스 등) , 무결성 제약 정보, 함수 프로시저 및 트리거 등

빅데이터 분석 방법론

하향식 접근 방식 ) 문제가 주어지고 이에 대한 해법을 찾기 위해 과정 진행 ( 지도 학습)

문제 탐색 -> 문제 정의 -> 해결방안 -> 탐색 타당성 검토

상향식 접근 방식 ) 비지도 학습 방법에 의해 데이터 분석

인사이트 도출 후 반복적인 시행착오를 통해 수행하며 문제를 도출하는 과정

프로세스 분류 -> 프로세스 흐름 분석 -> 분석요건 식별-> 분석요건 정의

상관분석

: 데이터 안의 두 변수간의 관계를 알아보기 위한 것

> 상관관계의 절댓값이 0이면 전혀 상관이 없는 것이고, 0.3보다 작으면 거의 상관 없는 것

0.3~0.7사이면 약한 상관관계 , 0.7~1 사이면 강한 상관관계 있는 것

> cor() 혹은 rcorr() 함수로 상관관계 구할 수 있다.

R로 상관분석 했을 때, p-value 값이 0.05이하인 경우 귀무가설을 기각하고 대립가설을 채택할 수 있다. 즉 변수 간 상관관계가 있다고 볼 수 있다.

척도

i) 명목척도 ex 남자-1, 여자-2 / 단순히 측정 대상의 특성 분류 확인 목적

ii) 서열척도 ex) 기말고사 성적 순 1등,2등,3등 / 대소 또는 높낮이 등의 순위만 제공할 뿐 양적 비교 x

iii) 등간척도 ex) 관찰 대상의 속성을 크기로 나타냄 , 순위를 부여할 뿐 아니라 어느 정도 큰지 숫자간 의미 있음 / 순위를 부여하되 순위 사이의 간격이 동일하여 양적 비교 가능

-> A는 1점, B는 2점, C는 5점 이라 했을 때 C가 A보다 훨씬 좋을 뿐만 아니라 C가 A에 비해 5배나 좋다는 것을 알 수 있 음

iv) 비율척도: 연속적인 수로 수량화할 수 있으며 절대적인 원점이 존재한다.

'0'이라는 값은 없다고 할 수 있다. 사칙연산 가능

e.g. 몸무게, 인구수, 길이

절대 영점이 존재하기 때문에 몸무게 0kg은 몸무게가 없다고 할 수 있다는 것공분산

: 임의의 두 확률변수 X,Y 사이의 선형관계, 얼마만큼의 관계가 있는지 알려줌

> 단위에 영향을 크게 받음

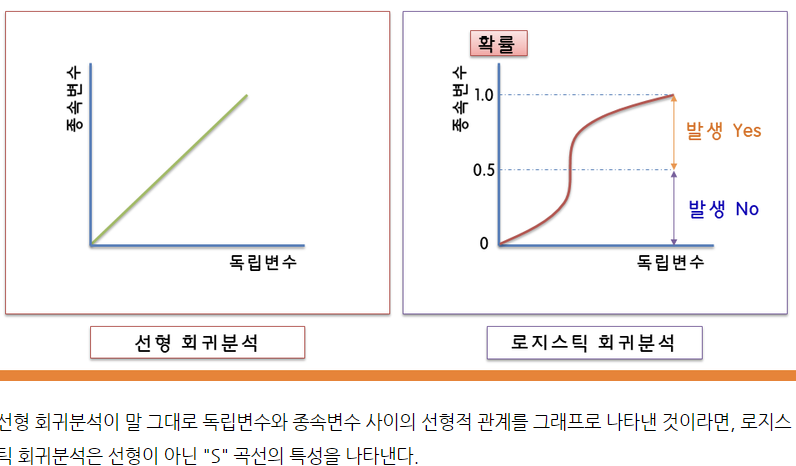

회귀분석

: 하나 또는 그 이상의 독립변수들이 종속변수에 미치는 영향을 추정하는 통계법

> p-값이 0.05보다 작으면 추정된 회귀식은 통계적으로 유의수준 5% 이하에서 유의미하다고 봄

> 결정계수는 r-squared 값으로 확인하면 되고 1에 가까울수록 설명력이 높다고 판단할 수 있음

모델을 만들었을 때 엄청 불균형한 모델을 좀 더 단순화하게 하기 위해서 규제를 가하게 됨 , 대표적으로 라쏘와 릿지

독립변수의 수가 지나치게 많거나 변수간 다중공선성이 크다고 여겨질 때, 회귀 모델의 적합 성능을 향상시키기 위해 변수선택이나 차원 축소 + 규제 방법을 선택할 수 있다. 방법은 회귀계수를 구할 때, 회귀 계수의 크기에 제약을 두어 설명력이 낮은 독립변수에 대한 가중치를 줄인다.

회귀계수:

:설명변수들 중에서 한 설명변수를 제외한 나머지 변수들에 변동이 없다는 전제하에 한 설명변수가 한 단위 증가에 따른 반응변수에서의 변화를 나타내는 양

> 다중회귀모형에서 결정계수의 값은 상관계수의 제곱 값과 같다

> 회귀분석에서 서로 다른 설명변수의 상대적 중요도를 측정하는 기준은 표준화 회귀계수가 가장 큰 변수이다.

비표준화 계수: 독립변수 1만큼 증가할 때 종속변수가 얼마나 증가하는지 나타냄

ex) ,직원의 서비스교육의 질이 높아질 때마다 서비스 만족도가 높아진다 가정할 때, 서비스 만족도에 미치는 비표준화계수가 0.55라고 한다면, 직원의 서비스 교육 질이 1만큼 증가하면 서비스 만족도 0.55배 증가한다

표준화 계수: 독립변수들이 종속변수에 미치는 영향력

ex) 연령0.55, 교육 0.31,근속연수 0.11이라고 하면, 수행에 가장 큰 영향을 미치는 것은 연령 55%

Lasso 회귀분석

> 회귀계수의 절댓값이 클수록 패널티 부여

> 독립변수가 많아질수록 훈련 데이터의 설명력이 좋아지지만 과적합 문제 발생할 수 있음

> 람다값이 너무 크면 모든 항들에 대하여 너무 많은 패널티가 적용되므로 모델에 데이터를 잘 설명하지 못하는 underfiting 문제 발생할 것이다

>L1 패널티 사용

> 자동적으로 변수선택의 효과 있음

로지스틱 회귀분석

: 반응변수가 범주형인 경우 적용되는 회귀분석 모형

> 로지스틱회귀분석의 모형 탐색은 최대우도추정법을 이용함

> 로지스틱 회귀분석은 독립변수에 대한 어떠한 가정도 필요하지 않음

> 로짓변환을 통해 곡선을 직선 형태로 변환할 수 있어 직관적 해석 가능

> 로지스틱 회귀분석은 카이제곱 검정 실시

ex) 웹 사이트 방문자가 장바구니에서 결제 버튼을 클릭하지 말지 여부를 추측할 때 , 로지스틱 회귀 분석은 웹 사이트에서 보낸 시간, 카트에 있는 항목 수, 과거의 방문자 행동을 살펴 봄 . 그런 다음 과거에 방문자가 웹 ㅏ이트에서 5분 이상 시간을 보내고 카트에 3개 이상의 항목을 추가한 경우 결제를 헀다고 판단하고, 로지스틱 회귀 함수는 이 정보를 사용하여 새 웹 사이트 방문자의 행동을 예측할 수 있음.

로지스틱 회귀분석의 곡선에서 종속변수의 확률이 0.5보다 크면 어떤 사건이 일어난다고 보고, 0.5보다 작으면 어떤 사건이 이어나지 않을 것이라고 확률적으로 예측해볼 수 있다.

cf) https://m.blog.naver.com/y4769/221851780608

의사결정나무

> 연속적으로 발생하는 의사결정 문제를 시각화해 의사결정이 이뤄지는 시점과 성과를 한눈에 볼 수 있게 한다

> 에측력에 치중할 때도 해석력에 치중할 때도 있다

> 대용량 데이터서도 빠르다

> 비정상 잡음 데이터에 대해서도 민감함이 없다

> 상관성이 높은 다른 불필요한 변수가 있어도 크게 영향을 받지 않는다

> 새로운 자료에 대한 과대적합이 발생할 수 있다

> 아래로 내려갈수록 각 마디에서의 불순도는 감소한다

ex) 쉽게 말해서 스무고개를 그림으로 나타낸 것으로 생각할 수 있음. 예를 들어, 의료 분야에서 환자가 어떤 병에 걸렸을 떄 이러이러한 조건에 부합하기 때문에 어떠한 질병이 의심된다고 설명할 수 있음

의사결정나무 알고리즘

> CART : 출력변수가 범주형일 경우 지니지수, 연속형일 경우 이진분리 사용

> C4.5/ C5.0: 범주형 입력변수에 대해서는 범주의 수만큼 분리가 일어남, 측도로는 엔토리피지수 사용

>CHAID : 가지치기 없이 적당한 크기에서 나무 성장 중지, 입력변수는 반드시 범주형 사용, 측도로는 카이제곱 통계량 사용

카이제곱 통계량의 p값은 그 값이 작을수록, 지니 지수와 엔트로피 지수는 그 값이 클수록 자식노드 내의 이질성이 큼을 의미하며, 따라서 이 값들이 가장 작아지는 방향으로 가지분할 수행 / 엔트로피 지수 P = 0.5일 때 이질성 가장 크다

카이제곱 통계량의 p-값은 그 값이 작을수록 자식 노드 내의 이질성이 큼을 의미

지니지수 = 불순도 측도 지표 / 낮으면 낮을수록 순수도가 높다

범주형일 때 지니지수 / 엔트로피 지수

연속형일 때 분산감소량/ F -통계량의 p-값

> *이익도표 또는 검정용 자료에 의한 교차타당성 등을 이용해 평가함

확률분포의 유형

1) 이산확률분포 : 확률변수가 정수의 값을 가지는 경우 이항분포, 포아송분포, 초기하분포, 기하분포, 다항분포

2) 연속확률분포 : 확률변수가 소수점 값을 포함하는 실수 값을 가지는 경우로 정규분포, 표준정규분포, 지수분포, t-분포, F-분포, 카이제곱 분포

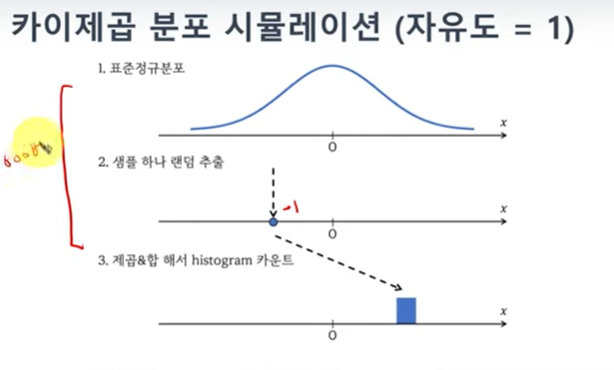

카이제곱 검정

: 카이제곱 검정은 범주별로 관측빈도와 기대빈도의 차이를 통해서 확률 모형이 데이터를 얼마나 잘 설명하는지 검증하는 통계적 방법-> 로지스틱 회귀

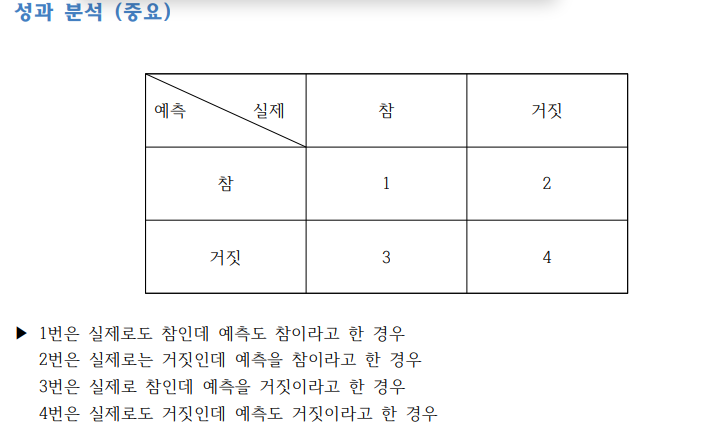

ROC 커브

: x축 1-특이도 / y축 민감도

> 그래프의 면적이 클수록 (1에 가까울수록) 성능 좋다고 평가

> 가장 이상적으로 완벽한 분류 모형은 x 축은 0, y축은 1일 때

> y축을 참긍정률(TPR) , x축을 거짓긍정률(FPR) 이라 하면 이 둘의 관계는 서로 반비례 관계

KNN 최근접 이웃 알고리즘

비슷한 애들 끼리 모이는 것 , 지도학습인 반면 클러스터링은 비지도 학습

> 거리 측정 시 유클리디안 거리 계산법 사용

장점 : 단순하고 효율적이다 , 사례기반 학습이라 데이터 분포에 대한 가정을 하지 않고 훈련 단계가 빠르다

단점: 모델을 생성하지 않아 특징과 클래스 간 이해에 제한적이다 , 적절한 K 의 선택이 필요하다 , 데이터가 많아지면 분류 단계가 느리다, 명목 특징 누락 데이터를 위한 추가 처리가 필요하다 ( 더미코딩 ) , 데이터 지역 구조에 민감하다

회귀분석 변수 선택

> 종속변수를 설명하는데 도움이 안 되는 독립 변수가 존재할 수 있음, 따라서 이런 변수들을 제거해야 되고 이 기준을 AIC, BIC로 선택함.

> 간단하게 말해 AIC, BIC는 안 좋은 독립변수에 패널티를 주는 지표로 적을수록 좋음

AIC (Akaike information criterion)

> 모델 성능 지표로 MSE 에 변수 수 만큼 패널티 주는 지표

> 일반적으로 회귀분석에서 모델 선택 시 많이 쓰는 지표

BIC (Bayes information criteria)

> AIC 단점은 표본 n 이 커질 때 부정확해짐

> 이를 보완한 지표가 BIC (AIC 와 큰 차이는 업지만 표본이 커지면 좀 더 정확함)

회귀분석 영향력 진단

: 회귀분석의 안전성을 평가하는 통계적인 방법

1) Cook's Distance (쿡의 거리)

> i번째 관측치 포함/ 미포함에 따른 적합치 사이의 거리 계산

> 쿡의 거리가 기준값인 1보다 클 경우 영향치로 간주

2) DFBEATAS

> i번째 관측치가 DFBEATAS값이 기준값인 2 혹은 2/sqrt(n)보다 크면 영향치로 간주

3) DFFITS

> i번째 관측치 제외 시 종속변수 예측지치의 변환정도를 측정한 값

> 기준값보다 클수록 영향치일 가능성이 높음

4) Leverage H

> 관측치가 다른 관측치 집단으로부터 떨어진 정도 의미

> 기준값 (=2*(p+1)/n) 보다 크면 영향치 이거나 이상치로 봄

데이터 부넉 과제 관리 5가지 주요 속성

1) 데이터 사이즈

2) 데이터 적용성 Complexity

3) Speed

4) 분석 복잡도 , 정확도아 복잡도의 관계 , 분석 모델이 복잡할수록 정확도는 올라가지만 해석이 어려움

5) 정확도와 정밀도 / 정확도는 활용 측면에서 중요, 정밀도는 안전성 측명에서 중요

* 정확도 : 모델과 실제 값 사이의 차이가 적다는 것을 의미

* 정밀도: 모델을 지속적으로 반복했을 때 편차 수준으로써 일관적으로 동일한 결과를 제시한다는 의미

자기상관

: 시간 또는 공간적으로 연속된 일련의 관측치들간에 존재하는 상관관계

ex) Duesenberry 의 상대소득가설(relative incone hypothsis)에 의하면, 소비자들의 지속적인 소비행태로 인해 소득이 줄어도 소비는 급 격하게 줄지 않는다

> 시계열자료 (time series data)에서는 현재의 상태가 과거와 미래의 상태에 밀접한 연관을 지니는 경우가 많다. 이럴 때 자기상관 (autocorrelation) 또는 계열상관 (series correlation)이 있다고 한다

> 문제점: 최소자승추정량(OLS) 은 불편성은 유지하나 효율성은 상실하게 되고, OLS 추정량이 갖는 분산은 실제보다 과소추정되어 추정량의 신뢰구간을 위축시키고 유의성 검증 통계량이 부담하게 커짐에 따라 귀무가설을 부당하게 기각시킬 가능성이 높아진다

다중회귀 분석법

1) 잔차 : median을 가운데로 두고 다른 분위수가 대칭적으로 나타나는지 살펴봐도 무방

2) 추정치 :각 변수에 따른 회귀계수(intercept) 로 회귀직선의 y절편, 나머지는 변수마다의 단위변화율을 나타낸다.

유의수준에 따라 결과가 달라지는데 유의수준 5%에서는 귀무가설이 기각되지 못함

3) 표준오차

4) t-value : 장도 n-p-1 의 자유도 t-분포를 따르는 검정통계량이다 , 회귀계수가 통계적으로 유의한지 가설검정 할 수 있다

5) p값 : p값이 작다는 것은 회귀계수가 유의하다는 뜻

5) 수정설명력 : 분석이 변수의 갯수에 비해 데이터를 얼마나 잘 설명하는가를 나타내는 척도로써, 높을수록 좋다

7) F통계량 : 이것의 p-value가 작다는 것은 유의한 회귀계수가 있다는 뜻이고, 회귀계수의 t검정이 회귀계수 하나하나에 대한 검정이라면 F검정은 회귀분석 자체에 대한 검정이다.

통계량

: 샘플의 함수

평균과 분산이 있음

검정력: 대립가설이 맞을 때 그것을 받아들이는 확률

카이제곱 분포

: 표준정규분포로부터 무작위로 얻는 랜덤 변수들의 제곱 합

> 카이제곱 분포는 오차 혹은 편차 분석에 도움 됨 , 보통 오차를 정규분포로 모델링하기 때문

> 중심극한정리에 따르면 샘플 수가 무수히 많고 합을 이용해 오차를 정의하면 그 오차의 분포는 정규분포이다

>> Mean Squared Error 같은 경우 예측값-실제값을 제곱한 것을 합해서 샘플 N수로 나누고, 이는 정규분포를 따르기 때문이다

> 따라서, 카이제곱 분포를 이용해 오차를 검증하면 오차가 우연히 발생한 것인지 숨겨진 의미가 있는 것인지 판별할 수 있다

적합도 검정

: 독립변수가 하나이고 이론적으로 기대되는 빈도의 분포와 관찰한 빈도의 분포 비교ex) 5개 종류의 사탕이 섞여 있는 바구니에서 100개 사탕을 마구잡이 골랐다고 해보자.

예측하기로는 5종류의 사탕이 골고루 섞여 있다고 생각한다. 우리가 고르게 된 사탕의 빈도를 관찰했을 때, 바구나 안의 사탕은 골고루 5종류가 잘 섞여 있다고 말할 수 있을까?

ㄹㄹ

얻은 통계량 7.9가 9.48 수치보다 적으니 유의미한 차이는 없다. 우연히 발생한 것이다 라고 예상할 수 있음.

교차분석 : 범주형 변수가 여러 경우에 적용하는 분석 방법

ex) 중국집은 짜장면, 짬뽕, 마라탕 세 개의 메뉴가 있다

cf) 공돌이의 수학노트 참조

t값, 자유도, p value값 이 값들중 어떤 걸 보느냐, 큰 값을 본다

이 값들의 크고 작음이 중요한가

t값이 크다 , 차이가 있다 / 모델이 의미가 있다라고 봄

t값, F값, 카이제곱 값 크고 작다는 것이 중요함, 크고 작음을 판단하기 위한 단위가 있을까

키 -> 180cm 라고 하면 평균보다 큰 값

토익점수-> 180이라고 하면 엄청 작은 값

그러니 단위가 있어야 판단할 수 있지 , 그렇지만 단위가 없을 경우 분포를 알아도 크기를 알 수 있음.

카이제곱 분포

: 범주형 자료에 대한 적합도 검정

t분포

: 정규분포 혹은 표준정규분포(Z-분포)와 유사한 부포로 t=0에 대해서 종 모양으로 대칭되는 형태

> 통상 모표준편차를 알 수 없고 표본 크기가 ㅈ가을 경우(n<30) 평균차이 추정의 기준으로 t분포를 삼음

F분포

: 두 집단의 분산을 비교하기 위해 사용하는 분포로, 정규분포를 이루는 모집단에서 독립적으로 추출한 표본들의 분산비율이 나타내는 연속 확률 분포이다.

: 분산분석과 회귀분석의 통계적 추론에서 기준이 되는 표본분포

> 표본분산과 자유도가 항상 양수이기 때문에 F값은 항상 양수를 가짐

SOM

:자기조직화지도, 눈으로 볼 수 있는 저자췅 녁갖에 고차원 데이터의 개체들이 대응하도록 인공신경망과 유사한 방식의 학습을 통해 군집을 도출해내는 비지도학습기법

입력벡터가 가장 유사한 N차원 벡터를 찾아 할당 됨

결과물 표본오차

ex1) 한 학교의 평균키를 알아보기 위해 임으로 5명을 선발하여 평균을 구했더니 173cm가 나왔는데,

알고보니 학생 500명의 평균이 185cm 인 경우

ex2) 투표 후 출구조사에서 A후보가 앞설것으로 예상했는데 뚜껑을 열어보니 B후보가 크게 앞서는 경우 => 추출오차

표본추출오차

: 모집단을 대표할 수 있는 구성요소를 표본으로 선택하지 못했기 때문에 발생하는 오류, cf) 앞의 두 예시

비표본추출오차

: 표본 선택 방법과 무관하게 발생하는 오차, 표본의 특성값을 측정하는 방법이 부정확해서 발생하는 경우가 많은데

측정오차가 비표본추출오차의 주류를 이루고 있음

ex) 다섯 반이 체중을 재보니 다섯번쨰 반만 유독 평균체중이 컸는데 알고보니 오래된 체중계로 무게를 잰 경우

표본편의

: 표본의 숫자를 무작정 크게 한다고 해서 모집단을 정확하게 추정할 수 있는 것은 아니다

: 모수를 작게 혹은 크게 할 때 추정하는 것과 같이 표본추출방법에 기인한 오차 -> 확률화에 의해 최소화되거나 없앨 수 있다

* 확률화 : 모집단으로부터 편의되지 않은 표본을 추출하는 절차 , 확률화 절차에 의해 추출된 표본을 확률표본이라 함

데이터웨어하우스

: 기업의 의사결정을 지원하기 위한 주제 중심적이고 통합적이며, 시간성을 가지는 비휘발성 자료의 집합

> 기업 내의 의사 결정 지원 애플리케이션을 위한 정보 기반을 제공하는 하나의 통합된 데이터 저장 공간

> 추출, 변환, 통합되고 요약된 읽기 전용 데이터베이스

데이터마트

: 전사적으로 구축된 데이터 웨어하우스로부터 특정 주제, 부서 중심으로 구축된 소규모 단일 주제의 데이터 웨어하우스

> 특정 부서의 의사결정 지원을 목적으로 부서별 또는 업무 기능별로 구축

데이터베이스

: 논리적으로 타당할 뿐만 아니라 데이터 검색, 조작,분석이 용이한 방식으로 저장된 정보의 조직화된 모음

모분산의 추론

: 정규모집단으로부터 n개를 단순 임의 추출한 표본의 분산은 카이제곱 분포를 따른다.

군집분석

: 각 개체의 유사성을 측정하여 유사성을 유사성이 높은 대상 집단을 분류하는 분석 방법

데이터 가공 단계

: 모델링 목적에 따라 목적변수를 정리하고 필요한 데이터를 마이닝 소프트웨어에 적용할 수 있도록 준비하는 단계

지도학습

: 로지스틱 회귀분석, 인공신경망, 의사결정나무

비지도학습

: SOM

* 향상도 곡선 (Lift Curve)

: 분류분석의 모형평가 방법으로 랜덤 모델과 비요하여 해당 모델의 성과가 얼마나 향상되었는지를 각 등급별로 파악

홀드아웃

: 데이터의 양이 충분하지 않거나 입력 변수에 대한 설명이 충분한 경우에 사용하는 모델평가 방법으로 주어진 데이터를

랜덤하게 두 개의 데이터로 구분하여 사용하는 방법

신경망 모형

> 역전파 알고리즘은 연결강도 갱신을 위해 예측된 결과와 실제값 차이인 에러를 통해 가중치를 조정하는 방법이다.

> 은닉층의 뉴런 수와 개수 정하는 것은 신경망 설계하는 사람의 직관과 경험에 의존한다

> 뉴런 수가 너무 많으면 과적합이 발생하고 뉴런 수가 적으면 입력 데이터를 충분히 표현하지 못하는 복잡한 이해를 할 수 없는 문제 야기

K-means 군집

> 사전에 주어진 목적이 없으므로 결과 해석이 어렵다

> 잡음이나 이상값에 영향을 많이 받는다

> k개의 초기 중심값은 임의로 선택해야 하고 , 군집이 형성되어도 군집 내 객체들은 다른 군집으로 이동할 수 있다.

> 이상치에 민감한 것을 군집의 중앙값을 사용하는 k-medoids 군집화 알고리즘이 있다

혼합분포군집 - EM 알고리즘

: 모형 기반의 군집 방법으로서 데이터가 k개의 모수적 모형의 가중합으로 표현되는 모집단 모형으로부터 나왔다는 가정 하에서 분석 하는 방법. k개의 각 모형 군집을 의미하며 이 혼합모형의 모수와 가중치의 최대가능도 추정에 사용되는 알고리즘은 EM 알고리즘이다.

* 사분면 영역에서 난이도와 시급성을 고려할 때 가장 우선적인 분석 과제는 난이도: 쉬움, 시급성 : 현재를 나타내는 3사분면이다.

분석 기획 시 고려사항

I) 가용 데이터 고려

II) 적절한 활용방안, 유스케이스 탐색

III) 장애요소에 대한 사전계획 수립

-> 수용, 전이, 회피,

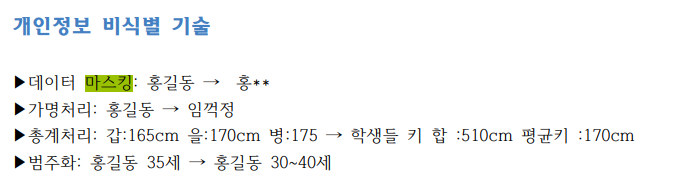

데이터 식별제한 방법

형태가 없는 본인만 아는 지식을 문서, 메뉴얼 등 형태가 있는 지식으로 변경한 것을 표출화라고 한

신뢰구간 점수 구하는 법

x는 평균, z는 확률값(1.645 등의), n은 표본값, s는 표준편차 자기회귀 모형 (AR)

: 시계열 모델 중 자기 자신의 과거 값을 사용하여 설명하는 모형

: 백색 잡음의 현재값과 자신의 과거값의 선형 가중합으로 이루어진 정상 확률 모형

* 백색잡음과정은 평균, 분산, 자기공분산이 일정한 정상성 데이터로 바꾸는 과정

이동평균 모형

: 이전 데이터의 오차에서 현재 데이터의 상태를 추론하는 방법, 과거와 현재 자신의 오차와의 관계를 정의한

ARMA 모델

: AR + MA 모델

* ARIMA(p, d, q)

- p : 자기 회귀 차수

- d : 차분 차수

- q : 이동 평균 차수비모수 검정

사용하는 때

I) 표본수가 30개 미만이면서 정규성을 만족하는 경우

II) 변수의 척도가 명목척도거나 서열 척도인 경우 ex) 대게 Rank (상대적 크기)를 많이 이용함

iii) 수치에는 의미가 업고 상대적 크기가 의미있는 경우

1. two -sample t-test : 양측검정의 결과

2. var.equal = True 등분산이 같다고 할 수 잇다

3. p-value값이 0.05보다 커서 통계적으로 유의하지 않음

4. two-sample test라서 n-2 =1923 , one sample test n-1 =1923 이었을 것

*다중대치법: 결측치를 가진 자료 분석에 사용하기 쉽고, 통계적 추론에 사용된 통계량의 효율성 및 일치성 등의 문제를 부분적으로 보완해준다. 그러나 추정량 표준오차의 고소추정 또는 계산의 난해성의 문제를 여전히 가지고 있다

반응형